Sujet d’article : Analyse de données en temps réelle

Partagez cet article sur :

L’analyse de données en temps réel est devenue un pilier essentiel pour les entreprises modernes, permettant des prises de décisions instantanées basées sur des informations à jour. Contrairement à l’analyse traditionnelle, qui se base sur des données historiques, l’analyse en temps réel traite et interprète les données immédiatement après leur collecte.

Cet article explore les étapes nécessaires pour mettre en place une infrastructure d’analyse de données en temps réel, ainsi que les technologies et les bonnes pratiques associées.

Alors ? Vous avez envie de tout savoir sur ce sujet ?

Lisez jusqu’à la fin pour ne rien louper 😉 !

Pourquoi l’analyse de données en temps réel ?

Avantages

Prises de décisions rapides :

Les entreprises peuvent réagir instantanément aux événements du marché, améliorer le service client, et optimiser leurs opérations en temps réel.

Détection des anomalies :

Les systèmes peuvent identifier et signaler des comportements anormaux, ce qui est crucial pour la sécurité et la prévention des fraudes.

Amélioration de l’expérience utilisateur :

En ajustant les services et les offres en fonction des données actuelles, les entreprises peuvent personnaliser l’expérience utilisateur.

Cas d’utilisation

Finance : Surveillance des transactions pour détecter des fraudes.

E-commerce : Recommandations de produits en temps réel basées sur le comportement des utilisateurs.

Santé :Monitoring des patients et intervention rapide en cas de changement de leurs signes vitaux.

Les étapes pour une analyse de données en temps réel

1. Collecte des données

La première étape consiste à capter les données en continu. Pour cela, diverses sources de données sont nécessaires :

Capteurs IoT : Utilisés dans l’industrie et la santé pour collecter des données en temps réel.

Logs et événements système : Provenant des applications et des serveurs.

Flux de données des réseaux sociaux : Capturant les tendances et les sentiments en temps réel.

2. Ingestion des données

L’ingestion des données en temps réel nécessite une infrastructure capable de gérer de gros volumes de données rapidement. Les technologies couramment utilisées incluent :

Apache Kafka : Une plateforme de streaming distribuée qui permet de publier et de souscrire à des flux de données en temps réel.

Amazon Kinesis : Un service de traitement de données en temps réel proposé par AWS.

3. Traitement des données

Le traitement en temps réel implique de transformer, agréger et analyser les données immédiatement après leur ingestion. Les frameworks populaires pour ce type de traitement sont :

Apache Flink : Connu pour son traitement de flux avec une faible latence.

Apache Spark Streaming : Une extension de Spark pour le traitement de flux en temps réel.

Google Dataflow : Une plateforme de traitement de flux et par lots basée sur Apache Beam.

4. Analyse et visualisation

Une fois les données traitées, elles doivent être analysées et visualisées pour permettre la prise de décisions. Les outils d’analyse en temps réel comprennent :

Elasticsearch et Kibana : Pour l’indexation et la visualisation des données en temps réel.

Grafana : Pour les tableaux de bord et la visualisation de métriques en temps réel.

Tableau : Pour des analyses interactives et des visualisations dynamiques.

5. Stockage et archivage

Même si l’objectif est de traiter les données en temps réel, il est souvent nécessaire de les stocker pour des analyses ultérieures ou pour des raisons de conformité. Les solutions de stockage incluent :

Bases de données NoSQL comme Cassandra : Pour des écritures rapides et une scalabilité horizontale.

Data Lakes : Utilisés pour stocker des volumes massifs de données non structurées et structurées.

Les bonnes pratiques pour une analyse en temps réel

Scalabilité : Assurez-vous que votre infrastructure peut évoluer pour gérer une augmentation des volumes de données.

Faible latence : Pour économiser le temps, choisissez des technologies et des configurations qui minimisent le temps entre la collecte et l’analyse des données.

Fiabilité et tolérance aux pannes : Implémentez des mécanismes de redondance et de récupération pour garantir la continuité du service.

Sécurité des données : Vous devez protégez les données en transit et au repos avec des méthodes de chiffrement robustes et des contrôles d’accès stricts.

Surveillance continue : Utilisez des outils de monitoring pour superviser les performances de votre système et détecter les problèmes potentiels.

Apprendre à analyser les données avec Excel

L’analyse de données est une compétences très recherchés aujourd’hui. Surement, vous connaissez plusieurs personnes qui ont opté pour ce domaine dernièrement, ou encore quelqu’un qui a commencer à apprendre sur ce domaine pour faire une reconversion.

En fait, le monde d’aujourd’hui est axé sur les données, et nous devons s’adapter aux nouvelles compétences. C’est pourquoi si vous souhaitez aussi faire partie des personnes qui maitrisent cette compétences, nous vous suggérons les ressources nécessaires pour forger vos compétences dans l’analyse de données.

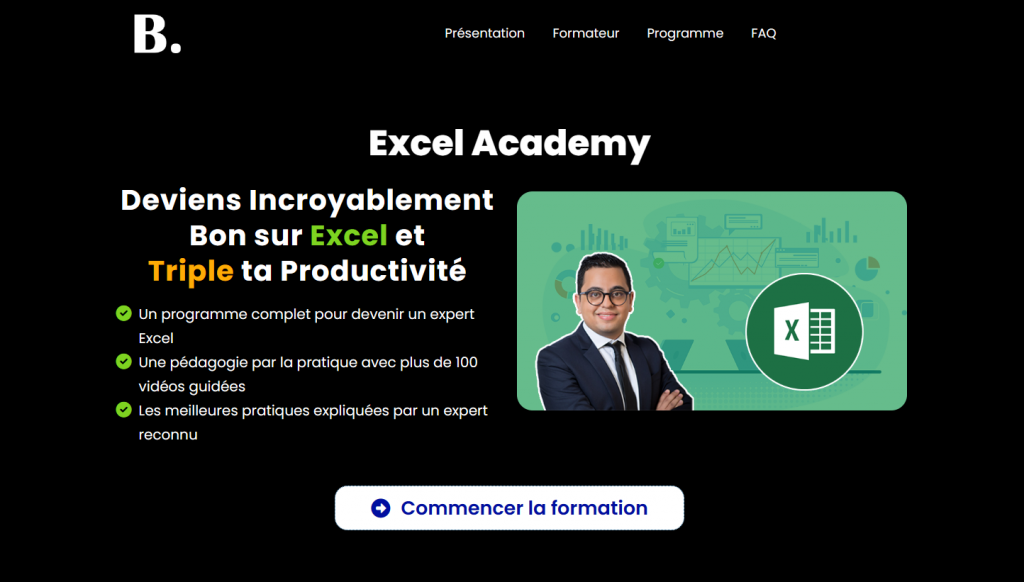

L’Excel Academy :

Cette formation compléter sur Excel porte sur un programme complet d’apprentissage d’Excel de A à Z. Le programme de formation comprend les sections suivantes :

- Les bases d’Excel

- Les formules et fonctions Excel

- Les tableaux croisés dynamiques

- La visualisation des données

- L’automatisation

- +3 projets guidés pas à pas

.

En plus de ça, cette formation est basé sur la pratique, vous aurez donc des capsules vidéos qui vous apprennent à la lettre ce que vous devez faire, pourquoi et comment, en plus vous bénéficiez aussi de l’accompagnement de votre formateur, qui est ex-consultant et expert en Data.

Vous avez aussi accès à des bonus exclusifs dont :

- 30+ exercices concrets corrigés

- Le cahier d’entraînement Excel

- Le mémo Excel

- La méthode pour reprendre le fichier d’un collègue

.

Vous aimez tout partagez ?

Partagez cet article avec quelqu’un qui en a besoin !

Vous pourriez aussi aimer lire :